Günlük yaşamın her anında bir takım kararlar vermekteyiz. Seçimlerimizin,

hayatımızı bambaşka bir yöne sürükleme gücüne sahip olduğunun farkındayız. Ve

tecrübelerimiz ile sabittir ki; Başarı

doğru zamanda, doğru yerde verilen iyi kararlara bağlıdır. Bireysel

yaşamdakine benzer şekilde organizasyonlar için de bu böyledir.

Organizasyonların başarısı yöneticilerin tam zamanında

verdiği doğru stratejik kararlara bağlıdır. Çoğu zaman doğru kararı vermek ise sübjektif yorum, tavsiye veya tecrübeden

fazlasını gerektirir.

Günümüzde adeta bir kasırga gibi firmaların etrafında

dolaşan rekabet, karar vericiler üzerindeki baskıyı giderek arttırmaktadır. Bu

acımasız mücadele ortamı devamlı zemini kaygan halde tutmakta ve birim zamanda

verilmesi gereken karar miktarını katlamaktadır. Firmalar geleneksel

yöntemlerle ayakta kalmaya dirense de nafile, artık ok yaydan çıktı. Piyasa

otokontrolü olmayan, dinamik olmaktansa hantal kalan hiçbir kuruluşa şans vermeyecektir.

Şimdilerde çoğu organizasyon mutfaktaki işlerin yanı sıra plan, program, senaryo, analiz, taktik,

strateji, simülasyon vs. gibi çalışmaların da önemli olduğuna ikna olmuş

durumda. Çünkü artık herkes istediği hizmete istediği kalitede istediği şekilde

ulaşabiliyor. Rakiplere karşı bir

avantaj sağlanabilmesi için taktik ve stratejilere kafa yormak, mevcut

durumu değerlendirip yeni yollar keşfetmek ve potansiyel getiriler arayışında bulunmak

zorunlu hale geldi. Bu çalışmaların doğru yapılabilmesi için sadece dünün tecrübesine ve bugünün güncel

bilgisine değil, yarının tahminlerine de ihtiyaç duyulmaktadır.

Önceki yıllarda

taktik ve strateji konusu önemli değil miydi?

Elbette önemliydi ve kuruluşlar buna çoğu zaman bir opsiyon

olarak kafa yormaktaydı. Fakat son zamanlarda karar vermeyi etkileyecek ham

veri o kadar çok farklı kaynaktan gelmekte ki bununla geleneksel yöntemlerle

mücadele etmek artık mümkün görünmüyor. Ayrıca artan rekabetten dolayı bu iş

opsiyon olmaktan çıktı ve bir zorunluluk haline geldi.

Firmalar verimliliklerini, dolayısıyla karlarını

arttırabilmek için çok çeşitlik kaynaklardan gelen verileri takip etmek ve

bunları analiz ederek anlamlı sonuçlar çıkarmak zorundalar. Bu veriler sensörlerden,

paylaşım sitelerinden, maillerden, anketlerden, istatistiklerden, cep

telefonu-radyo-tv gibi elektronik cihazlardan veya ilişkisel her hangi bir

kaynaktan gelebilir. Özetle structured,

semi- structured, unstructured bir yığın ham veri biriktirilebilir.

Kolayca içinden çıkılamaz hale gelebilecek bu

veri yığını, rekabette fark oluşturacak nitelikte, doğru zamanda, doğru

formatta ve güvenle karar vericilere ulaşabilecek şekilde bilgiye

dönüştürülmelidir. Bu, tam da iş zekâsı(Business Intelligence) ile üstesinden gelinebilecek bir ihtiyaçtır.

İş zekâsı nedir?

İş zekâsı, karar vericilerin işletme kararlarını daha iyi

verebilmelerine yardımcı olmak için gerekli olan teknolojileri kapsar. Verileri depolama, analiz etme, dağıtma,

veri kalitesini arttırma ve bilgiye güvenle erişimi sağlama iş zekâsının genel

yetenekleridir. Özetle iş zekâsı anlamlı sonuçlar üretebilmek için veriyi

bilgiye çevirir.

İş zekâsı projeleri uzun soluklu olup firmalarla ile

birlikte yaşayıp gelişmektedir. Bu tip projelerde birçok teknoloji ve ürün bir

arada bulunur. Microsoft odaklı düşünürsek projelerde kullanılabilen ürünlerden

bazıları şunlardır:

- MS SQL Server

- Reporting Services (SSRS)

- Analysis Services (SSAS)

- Data Mining

- Integration Services (SSIS)

- SharePoint

- Performance Point

- Office 365

- Excel (Power BI)

- Mobile Applications.

Bu ürünleri projelerde etkin bir şekilde kullanabilmek ciddi

manada uzmanlık gerektirmektedir. İlgisi ortalamanın üzerinde olan bir kişi

yoğun eğitim sürecinden geçtikten sonra bir Senior BI Developer yanında birkaç

farklı projede etkin olarak çalışırsa, ikinci yılın ardından iş zekâsı

projelerinde bazı noktalarda kendisine güvenilmeye başlanabilir. İş zekâsı

alanındaki uzmanlık birkaç programı kullanmak ve birkaç satır kod yazmaktan öte

şeyler gerektirmektedir. Öyle ki IK süreçlerinde bulunarak 6,7 yıl tecrübeli

adayların bile konsepti hatalı algıladıklarını gözlemlemekteyiz. Aslında iş zekâsı

uzmanlığı süreden daha çok farklı sektör çalışanları ile birlikte projeler

geliştirmeye bağlıdır.

Gerçekten tecrübeli kişilerle başlanılan bir projede bile

birçok sıkıntılı süreçle karşılaşılmaktadır. Bu sıkıntılar teknoloji, insan ve taktik konularının alt başlıklarında saatlerce

konuşulabilir. Bu sıkıntılardan belki de

en çok karşılaşılabilecek olanı ve zararsız görüneni günlük gelişen taleplerdir.

İş zekâsı trendinin aşağıdaki gibi olması bu tür anlık taleplerin

her geçen gün daha da artacağını işaret etmektedir.

Birkaç yıl sürmesi planlanan bir proje esnasında

geliştiriciler uzun vadede çok daha fazla katma değer üretecek çalışmaları

bırakıp günlük taleplere cevap vermeye başlarsa bu projenin başarısı hayal olur.

Normal iş zekası proje geliştirme yöntemi ile günlük ihtiyaçlara cevap vermek neredeyse

imkansızdır ve bu şekilde çalışmak çok fazla efor gerektirir. Ayrıca dar

zamanda ortaya çıkan ürünün, örneğin bir raporun katma değeri çok düşük olabilir. Bu nedenle son zamanlarda adını

sıkça duyduğumuz Self-Service BI

kavramı ortaya atılmıştır.

Self-Service BI nedir?

Self-Service BI bir nevi kendin pişir kendin ye mantığında

iş zekâsıdır. Özetle bu kapsamda, anlık ve sunum odaklı iş zekâsı ihtiyacı, teknik yeterlilik beklenmeyen bilgi

çalışanları(Information Worker)

tarafından kolayca adapte olunabilecek araçlar vasıtasıyla üretilebilmektedir.

Bu sayede teknik ekibe ihtiyaç azalmış ve sonuç itibariyle hem bilgi

çalışanları hem de teknik ekip maksimum

fayda sağlanabilecek konulara odaklanabilir olmuştur.

Microsoft bu alandaki ürünlerini yıllar öncesinden

müşterilerine çeşitli şekillerde sunmaktaydı. Şimdiler ise neredeyse tüm BI

ihtiyacını karşılayabilen çok daha yetenekli yeni ürünlerini Power BI adı altında bir araya

getirmektedir.

Son durumda Power BI kapsamında bir biri ile ilişkili dört

üründen bahsedebiliriz.

Bunlar ürünler şunlardır;

Excel: Excel 2013

için PowerPivot, PowerView,

PowerQuery ve PowerMap eklentileri mevcut iken Excel 2010 için sadece

PowerPivot ve PowerQuery eklentileri mevcuttur.

Power BI for Office

365:Office 365 üzerindeki portal hizmeti SharePoint Online olarak isimlendirilir.

SharePoint kadar yetenekli olmasa da ortalama ihtiyaçları karşılayabilen bu

ürüne SharePoint Store’dan indirilen Power BI bileşeni entegre edilebilmektedir.

Office 365’e bağlanıp PowerView raporlarını Mobile App. üzerinden mobile cihazlarda sunabiliriz. Ayrıca Power BI sayesinde raporları HTML5’e

dönüştürerek diğer cihazlarda da görüntülenmesini sağlayabiliriz. Ek olarak Q&A özelliği ile doğal cümlelere cevaben

veri modellerimizden anlık raporlar elde edebiliriz.

SharePoint: Burada

Excel dosyalarını paylaşabilir, versiyonlama, zaman bağlı olarak güncelleme

gibi daha birçok özelliği kullanabiliriz. PowerPivot ve PowerView odaklı

çalışan PowerPivot Galeri bu ürün

dahilinde kullanılabilmektedir. Excel içindeki PowerView raporlarını görüntülemeye

ek olarak, web ara yüzü ile PowerView raporları oluşturulabilir ve PowerPoint

sunumu olarak çıktı alabiliriz.

Power BI Mobile App.:

Windows Store’dan indirilebilen bu uygulama ile Office 365’e bağlanabilir, buradaki

raporları mobil cihazlarda veya Windows işletim sistemli bilgisayarlarda

görüntüleyebiliriz.

Nasıl yapılıyor?

Geliştirme şu dört Excel eklentisi yardımıyla yapılmaktadır;

PowerPivot:

Verilerin hızlı ve kolayca analiz edilebilmesi için OLAP

model tercih edilmelidir. OLAP model Multidimensional,

Tabular ve PowerPivot ile oluşturulabilir. Bunların birine göre avantajları ve

dezavantajları vardır.

Excel 2010 ve Excel

2013 üzerinde kullanılabilen bu eklenti yardımıyla OLAP veri modeli kolayca oluşturulabilir. Bu

veri modeli sayesinde veriler hem yüksek

sıkıştırma özelliğiyle daha az yer kaplar hem de in-Memory özelliğiyle memoryde tutularak çok daha hızlı analiz

edilebilir.

Oluşturulan bu modelleri klasik dosya paylaşım yolları ile

dağıtabileceğimiz gibi SharePoint portalini de kullanabiliriz. Tercihimiz

SharePoint olduğunda güvenlik, verinin

güncel tutulması, versiyonlama ve raporlama gibi birçok ihtiyaca da kolayca

cevap verebiliriz.

Bu veri modelini SharePoint

Online (Office 365) üzerinden paylaşmayı tercih ettiğimizde SharePoint Store’dan indirebileceğimiz Power BI bileşeninin Q&A özelliği sayesinde, kurduğumuz

doğal İngilizce cümlelere cevap olarak anlık

raporlar elde edebiliriz. Bu özelliğe birazdan değineceğiz.

Veriyi bir zamanlamaya bağlayarak belli aralıklarda

güncellemek için SharePoint’de kullanılan Data

Refresh özelliği SharePoint Online’da mevcut değil. Yani belli aralıklarla

güncellemeyi gerektirecek veri modellerini SharePoint Online(Office 365)

üzerinden yayınlamak dosya yönetimini zorlaştıracaktır.

PowerView:

İlk haline göre oldukça gelişen bu raporlama yöntemi sayesinde

sunum odaklı, animasyon ağırlıklı raporları sürükle-bırak yöntemiyle kolayca oluşturabiliyoruz.

PowerView raporları iki şekilde oluşturulabilir.

- Excel 2013 eklentisi ile bir Excel sayfasında

- Geliştirme PowerView eklentisi ile yapılır.

- Oluşan Excel dokumanı klasik dosya paylaşım yöntemleri, SharePoint veya Office 365 ile dağıtılabilir.

- Raporlar, Power BI Mobile uygulaması ile Office 365’e bağlanılarak mobil cihazlarda da görüntülenebilir.

- Silverlight tabanlı bu PowerView raporlarının tüm cihazlarda görüntülenebilmesi için HTML5 görünümüne geçilebilir (Office 365). Bazı görsellikler henüz HTML5’e render edilememektedir.

- SharePoint 2010-2013 üzerinde PowerPivot galeride

- Geliştirme web ara yüzü yardımıyla yapılır. RDLX uzantılı raporlar oluşur.

- PowerView raporları ilk duyurulduğunda(SharePoint 2010) bu şekilde oluşturulabilmekteydi. Ancak sadece tabular/powerpivot kaynaklar kullanılabiliyordu. Şimdi ise(SharePoint 2013) bir datasource oluşturularak OLAP küplerindeki veriler de raporlanabiliyor.

- Buradaki PowerView raporlarını, PowerPoint sunumu olarak kaydedebiliyoruz.

- SharePoint Online(Office 365) üzerinde bu şekilde bir geliştirme yapılamamaktadır. Sadece Excel içindeki PowerView raporları görüntülenebilmektedir.

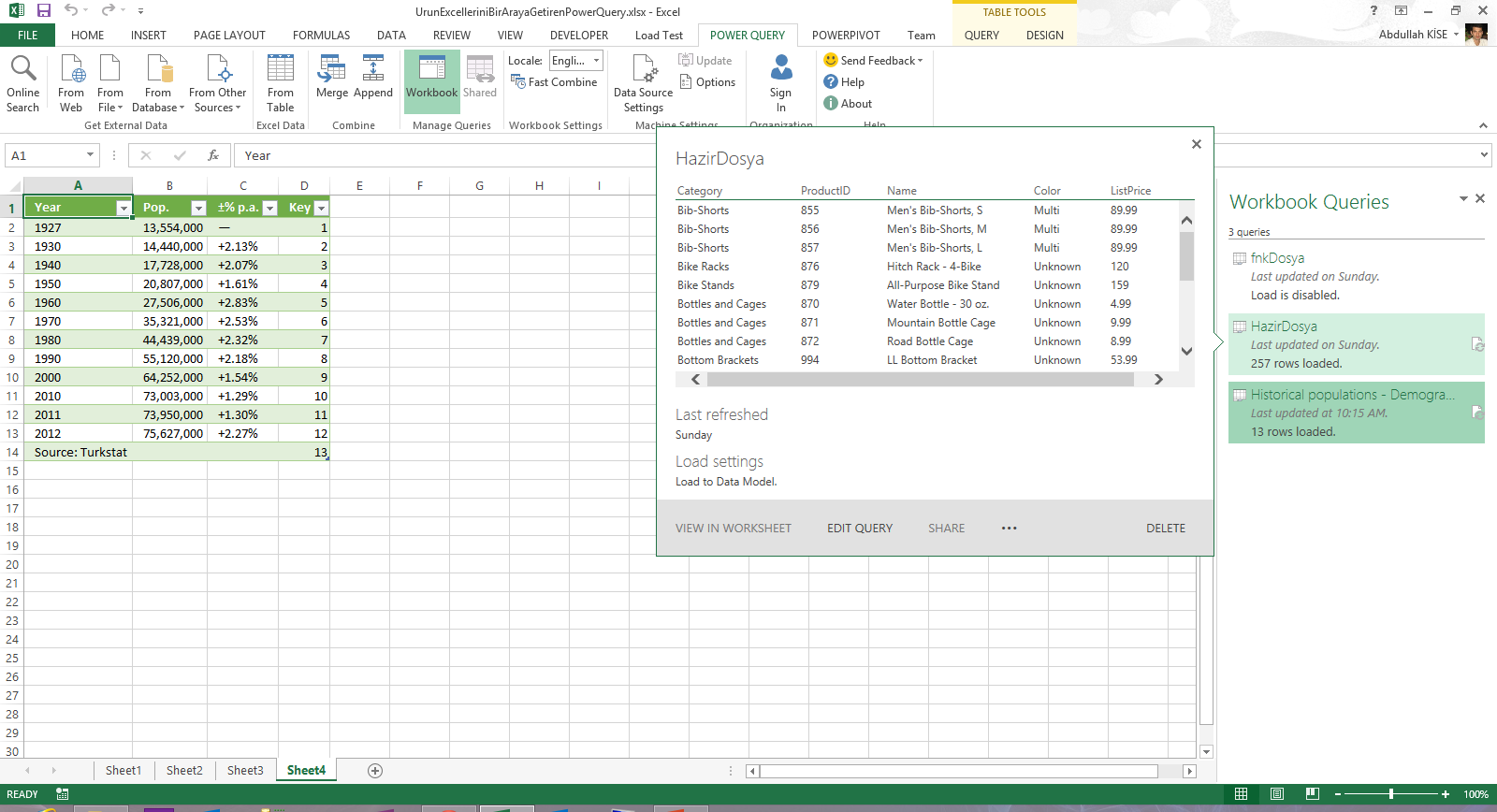

PowerQuery:

Bir nevi ETL

aracıdır. Verinin temin edilmesi ve hazırlanması için çeşitli kaynaklara

bağlanır. Veri üzerinde yapılan değişikler Query

adımları olarak tutulur. İstenirse bu Queryler daha sonra kullanılmak üzere Office

365 üzerinde paylaşılabilir.

PowerQuery, alışık olduğumuz kaynaklara ek olarak, Online Search, From Web özellikleri ile

bir web sitesi içerisindeki tablolara bağlanmanıza olanak tanır. Facebook, HDInsight ve Azure Storage gibi özellikleri ise

ileride çok daha fazla duyacağımız Big Data

çalışmalarında aktif rol alacağının işaretini vermektedir.

İstersek bir Gateway

yardımıyla bulutta on-premises veri kaynakları oluşturabilir, PowerQuery ile

onlarca tablo içerisinden belirttiğimiz anahtar kelimelere uyanları kolayca

listeleyebiliriz.

Excel 2013 üzerinde kullandığımız bu ürünü Excel 2010 ile

birlikte kullanmak da mümkündür.

Ocak 2014 yayınını şu adresten indirebilirsiniz.

PowerMap:

Bölgesel raporlama yapmak için dizayn edilmiş bir araçtır.

Bölge ismi, enlem-boylam gibi bilgiler temel alınarak çok katmanlı, 3 boyutlu sinematik raporlar üretilebilir. Bu

raporlar birer tur olarak kaydedilebilir ve bu turlar video çıktısı olarak alınabilir.

Bu Excel 2013 eklentisinin şu adresten temin edebilirsiniz:

Raporlarımızı video şeklinde veya Excel dosyaları içerisine gömülü

olarak SharePoint üzerinde dağıtmak mümkün.

Office 365 nedir?

Office 365 içerisinde Exchange,

Lync, Outlook, Calendar, SharePoint Online, Power BI for Office 365 vs.

gibi birçok hizmet ve özelliği barındıran bulut

tabanlı yeni bir üründür. Bu ürün Office tarafı için yeni bir lisanslama

modeli olarak kabul edilmektedir. Aşağıdaki alternatif lisans planları tercih

edilerek çeşitli hizmetler bir arada daha ucuza temin edilebilir:

- Academic Plans (A)

- Small Business Plans (P)

- Enterprise Business Plans (E)

- Government Plans (E)

- Kiosk Workers (K)

www.powerbi.com

adresinden bir deneme lisansı alarak Power

BI for Office 365 ürününü test edebilirsiniz. Şu linkten indirebileceğiniz

dokuman gerekli kurulumu kolayca yapabilmenizi sağlayacaktır.

Power BI için Office

365 gerekli mi?

Hayır, gerekli değil. Ancak ekstra özellikleri profesyonel

deneyimler sunacaktır.

Office 365 ile yapabileceklerimiz genel olarak şunlar:

Excel dokümanlarını ve PowerQuery sorgularını diğerleri ile paylaşabiliriz.

On-Premises serverları bir Gateway yardımıyla Office 365’te kaynak olarak belirtebiliriz. Bu

sayede PowerQuery aramaları ile yüzlerce tablodan istediğimiz bilgileri

saniyeler içerisinde temin edebiliriz.

Veri modellerimiz üzerinde Question and Answer (Q&A) özelliği ile arama motoru rahatlığında

sorgulamalar yapabiliriz. Bu sorgu sonuçları anlık olarak üretilen raporlar

şeklinde dönmektedir. Yazdığımız sorguya bağlı olarak akıllı bir şekilde tablo,

grafik veya harita çıktısı üretilmektedir. Tabi ki bu çıktılardan herhangi

birini bilinçli olarak tercih edebiliriz.

PowerView raporları sadece Silverlight destekleyen

cihazlarda görüntülenebilmektedir. Eğer diğer cihazlarda da görüntülemek

istersek Office 365 Power BI site üzerinde raporu açtığımızda çıkan HTML5 butonunu kullanabiliriz. Böylece

PowerView raporu tüm görselliklere şimdilik destek verilmese de HTML5 olarak render

edilecektir.

Windows Store’dan indirebileceğimiz Power BI Mobile uygulamasını kullanılarak Office 365’e bağlanabilir

ve PowerView raporlarımızı mobile cihazlarda görüntüleyebiliriz.

Limitler neler?

Veri

modeli limiti şunlar;

Ayrıntılı bilgi için şu adresleri ziyaret edebilirsiniz:

Veri modeli limiti için;

SharePoint 2013’ün BI kapasitesi için;

SharePoint Online ve Power BI for Office 365’in BI

kapasitesi için;

Power BI kapsamında değerlendirilen Excel eklentilerinin ve

Office 365’in yeteneklerini en özet haliyle incelemiş olduk. İlerleyen günlerde

gelişerek çok daha fazla amaç için kullanılacak olan Power BI şimdiden Self-Service BI’ın hakkını veriyor gibi

görünüyor. Takdir sizin.

Siz de organizasyonunuzda trendi takip ederek Power BI araçlarıyla

anlık analiz ve raporlama ihtiyaçlarının üstesinden kolayca gelebilirsiniz. Hem

de tüm Office çalışanlarınızın aşina olduğu bir ürün olan Excel’i kullanarak.

Power BI hakkındaki ayrıntılı bilgileri şu linkten

edinebilirsiniz:

Şu kısa ve keyifli sunuma da bir göz atmak isteyebilirsiniz:

Faydalı olması dileğiyle,